El desarrollo de rovers autónomos ha sido clave en las misiones de exploración planetaria llevadas a cabo en los últimos años, y lo seguirá siendo durante las misiones futuras debido a su efectividad y el aprovechamiento de recursos que estas tecnologías plantean.

Uno de los principales problemas de la exploración planetaria a nivel de superficie ha sido el difícil terreno por el cual se deben desplazar los rovers de exploración. Durante años, muchas de estas misiones se han visto afectadas por estos obstáculos, un ejemplo de ello fue el del rover Spirit, el cual terminó su misión de 7 años terrestres debido a que quedó atascado en la arena de Marte. Los algoritmos de Machine Learning ó “Inteligencias artificiales” como se les suele llamar popularmente han representado una solución oportuna para este problema.

El problema y sus antecedentes

La exploración de cuerpos celestes por medio de plataformas tipo rover controladas a distancia ha sido posible desde 1970 cuando la en ese entonces Unión Soviética alunizó exitosamente su rover Lunojod 1 con el objetivo de explorar y enviar las primeras imágenes de la superficie lunar de regreso a la Tierra. Fue hasta 1997 que la NASA logró el objetivo de poner su rover Sojourner de la misión Mars Pathfinder en la superficie de Marte como una tecnología para demostrar que era posible llevar instrumentos a la superficie del planeta rojo.

Como se mencionó antes, un rover pionero en la exploración de Marte fue el Spirit, el cual tocó la superficie del planeta el 4 de enero del 2004. Esta plataforma tuvo un papel importante en el desarrollo de tecnologías que tendrían un impacto mayor en misiones futuras ya que al extender su vida útil de 90 días a 7 años fue posible que la plataforma permitiera explorar más allá de lo planeado y por lo tanto encontrarse con mayores problemas de desplazamiento, debido a esto fue necesario el desarrollo de un parche en el software que le permitió tomar decisiones autónomas basadas en las lecturas de sus instrumentos, de esta manera la plataforma podía ser más efectiva al adentrarse en terrenos difíciles.

Aproximación con modelos de machine learning

Una definición muy acertada para el concepto de machine learning es la que se plantea en el artículo de Gavin Edwards “Machine Learning | An Introduction”:

Machine learning is a tool for turning information into knowledge.

Como su nombre lo dice, esta tecnología se basa en modelos que aprenden conforme reciben información, mientras mayor sea la base de datos de la cual se alimenta el modelo, mejores serán sus predicciones. Ejemplos cotidianos de esta aproximación son los algoritmos que implementan redes sociales como Twitter, que basa sus recomendaciones en relación al número de likes, comentarios, tiempo viendo un tweet, etc. que un usuario tiene respecto a cierto tema o persona en especial. El caso del algoritmo de Netflix también es muy interesante ya que además de basar sus recomendaciones en las películas que el usuario normalmente ve, también modifica las portadas de las películas o series que aparecen en pantalla para que sean más atractivas para el cliente en base a sus gustos. Si te interesa saber más de este algoritmo aquí puedes encontrar un análisis más detallado de su funcionamiento.

En la Geología Planetaria, estos modelos representan un avance increíble para el procesamiento de grandes cantidades de información como es el caso de las misiones con rovers de exploración planetaria, específicamente los rovers Curiosity y Perseverance que aterrizaron en 2012 y 2020 en Marte respectivamente.

El mayor reto para la implementación de estos modelos es la capacidad de cómputo y la distancia para enviar y recibir datos. En la siguiente tabla se hace una comparación de las distancias y tiempos que implican establecer comunicaciones a cuerpos tan lejanos como Marte.

| Especificaciones | Tierra - Luna | Tierra - Marte |

|---|---|---|

| Distancia | ~384,400 km | ~59,000,000 km |

| Tiempo en comunicaciones (ida y vuelta) | ~3.6 segundos | ~9.1 minutos |

| Tiempo de traslado | 4 - 5 días | 7 - 9 meses |

Soluciones con modelos de ML

Tomando en cuenta los retos antes mencionados, se han hecho múltiples propuestas por medio de modelos de ML para lidiar con el problema del desplazamiento. Es importante mencionar que las computadoras que estos vehículos cargan a bordo no suelen ser muy potentes en cuanto a su capacidad de procesamiento de datos ya que están enfocadas en recopilar información importante para ser enviada y analizada en la Tierra. Para no sobrecargar las computadoras de los rovers los modelos son entrenados en computadoras con mayor capacidad en la Tierra, posteriormente los modelos entrenados son cargados al software del rover, este proceso puede durar varias horas o incluso días dependiento de la actualización de software.

Deep learning con Redes Neuronales Convolucionales

Una solución oportuna se encontró en el deep learning, una subcategoría del machine learning que basa su funcionamiento en la forma que el cerebro humano reconoce el medio que lo rodea. El deep learning funciona en “capas” que abstraen la información que se le introduce al algoritmo, de esta manera cada capa puede reconocer patrones en la información que se le da al modelo (imágenes, videos, texto, etc.), por medio de estos patrones el algoritmo aprende mientras recibe más y más información. Aquí podemos ver un ejemplo de cómo funciona el deep learning en el reconocimiento facial:

- Se hace la detección del rostro en la imagen

- Se analizan las características faciales por separado

- Se comparan las características con otros rostros para encontrar patrones

- Se realiza la predicción

Las Redes Neuronales Convolucionales, CNN por sus siglas en inglés, son un algoritmo de deep learning que como su nombre lo dice, se basa en el funcionamiento de las neuronas del cerebro humano, cada una de estas neuronas artificiales se encarga de reconocer un patrón específico, que después será complementado por las demás neuronas en la red para hacer una operación matemática llamada convolución, que a grandes rasgos expresa cómo una capa de nuestra red neuronal está siendo afectada por la capa procesada anteriormente, cada vez filtrando los datos con una mayor precisión en cada capa hasta obtener la predicción final. Si te interesa leer un poco más de cómo funcionan las redes neuronales puedes consultar estos 3 artículos:

- “Introduction to Convolutional Neural Networks (CNN)” by Manav Mandal

- “A Comprehensive Guide to Convolutional Neural Networks — the ELI5 way” by Sumit Saha

- “Neural networks made easy” by Ophir Tanz and Cambron Carter

Soil Property and Object Classification (SPOC)

En 2016, el Jet Propulsion Laboratory (JPL) presentó un software que es capaz de identificar distintos tipos de terrenos y rocas tanto a nivel superficie como a nivel orbital por medio de imágenes. El software SPOC 1, por sus siglas en inglés, está construido con redes neuronales convolucionales, gracias a este método de deep learning es posible que el software aprenda de una pequeña cantidad de ejemplos provistos por expertos en Geología Planetaria, para que después el modelo aplique ese procesamiento a un volumen de datos mayor y haga predicciones cada vez más acertadas.

Este software fue entrenado inicialmente con aproximadamente 700 imágenes manualmente clasificadas por expertos, estas imágenes incluyen la identificación de tipos de rocas como regolitos, arenas, rocas fracturadas, etc, y tipos de terrenos como afloramientos escarpados o con tipos de rocas predominantes, incluso puede identificar fácilmente las marcas de las ruedas en los rovers. SPOC es capaz de hacer clasificaciones de rocas y terrenos de hasta 30 metros de distancia del rover. Es importante mencionar que este modelo no solamente se limita a clasificar tipos de terrenos o de rocas, también se implementó una predicción para calcular el ángulo de pendiente en ciertas zonas que podrían ser peligrosas para el rover.

El equipo que se encargó de desarrollar SPOC creó una página web en donde puedes leer más sobre este algoritmo, también hay una versión ligera del software que es open-source y puedes descargar y utilizar para algún proyecto personal:

- SPOC website. A Deep Learning-based Terrain Classifier for Mars Rovers

- SPOC-Lite. Open-source software

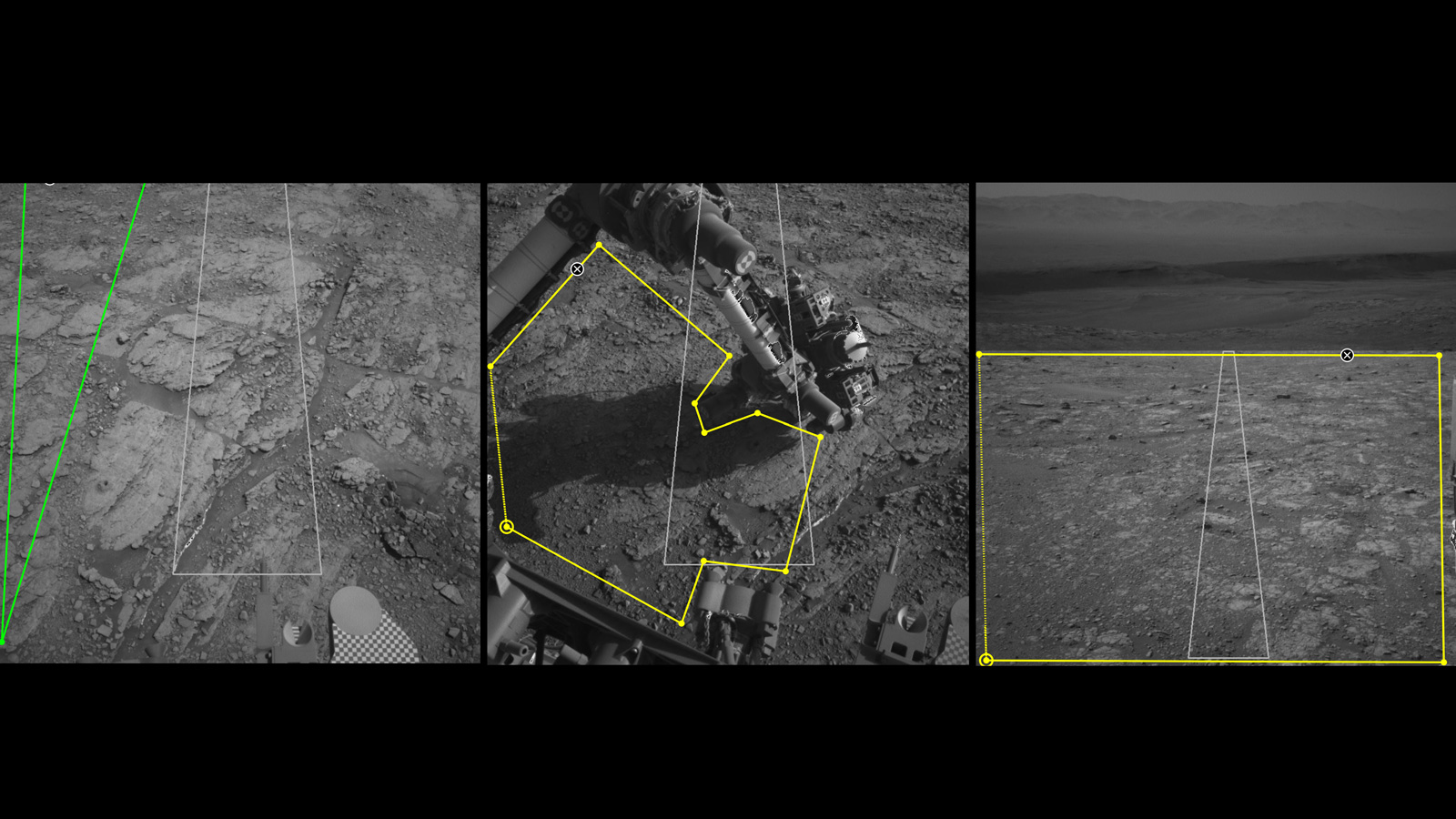

AI4Mars. Una herramienta pública para entrenar algoritmos de rovers en Marte

Como una iniciativa para involucrar al público en el desarrollo de estas nuevas tecnologías se creó AI4Mars, una herramienta que le permite a cualquier persona ayudar en la clasificación de tipos de rocas y terrenos para entrenar los algoritmos que ayudan a los rovers de exploración a manejar de manera completamente autónoma en los difíciles terrenos de Marte. La herramienta incluye una gran colección de imágenes tomadas en la superficie del planeta rojo, el usuario tiene indicaciones en cada imagen con las cuales puede clasificar varias características del terreno como fracturas, arenas, pendientes, etc. De esta manera es más sencillo obtener bases de datos más grandes que sirvan de entrenamiento para hacer modelos de mayor precisión, y a su vez, el público se puede familiarizar con las tecnologías que se emplean en la actualidad para la exploración planetaria.

Comentarios, sugerencias y opiniones

Espero que este post haya sido de interés para ti, si es así compártelo en tus redes. ¡Te lo agradecería mucho!

Si tienes algún comentario, sugerencia u opinión házmelo saber en los comentarios de abajo, no requieres de ninguna cuenta, sólo elige un nombre de usuario (puede ser tu nombre) y un correo (opcional). Todos los comentarios son enviados a un moderador, por lo tanto tardarán un poco en publicarse.